Alexa Steinbrück

The Literal Unseen

XLab

Künstliche Intelligenz visualisieren

Wie stellen wir uns künstliche Intelligenz (KI) vor? Als blaue, elektrifizierte Gehirne, humanoide Roboter oder sogar als bedrohlichen Terminator?

KI wird oft als etwas Abstraktes betrachtet: Algorithmen, Daten und Denken. Doch KI ist alles andere als abstrakt: vom Abbau seltener Erden, die die materielle Grundlage für die benötigten Hardware-Komponenten bilden, über die Praxis der Datenerfassung, die im öffentlichen Raum oft ungefragt passiert, bis hin zur monotonen Arbeit der Clickworker an den Datensätzen, die für das Training von KI-Modellen unerlässlich sind – nicht zu vergessen das Kohlendioxid, das bei all dem ausgestoßen wird.

Die Bilder dieser Serie wurden mit Hilfe eines KI-Algorithmus erzeugt, der Text in Bilder umwandelt. Die Künstlerin hat die Eingangstexte so formuliert, dass sie einige der übersehenen Aspekte von KI hervorheben. Sprache dient dabei als Remixing-Werkzeug, das Metaphern als sichtbare Realitäten entstehen lässt.

Die Visualisierung von KI mit Hilfe von KI ist ein Prozess von Co-Creation. Es handelt sich also nicht um das beeindruckende Selbstporträt einer superintelligenten KI. Denn das Bild von einem autonom handelnden KI-System mit eigenem Bewusstsein bleibt ein Mythos.

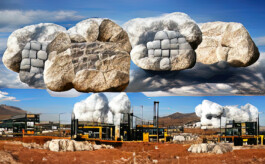

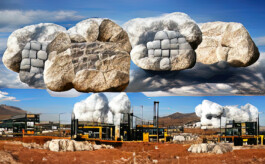

the cloud is made of rocks and lithium brine and crude oil

„The cloud is the backbone of the artificial intelligence industry, and it’s made of rocks and lithium brine and crude oil“, heißt es in Kate Crawfords Buch „Atlas of AI“. Der Begriff „Cloud“ beschreibt Computer-Infrastrukturen, die über das Internet verschiedene Services wie Datenspeicherung oder Rechenkraft bereitstellen. Der Begriff suggeriert etwas Immaterielles und Leichtes. Tatsächlich ist die Cloud nicht weniger materiell als die Smartphones oder Laptops, die wir in unseren Händen halten. Ein KI-System ist ein vielfältiges Netz von Computer-Infrastruktur, von Batterien über Netzwerk-Router bis hin zu großen Datacentern. Nichts davon funktioniert ohne die Minerale aus der Erdkruste. Lithium ist ein zentraler Bestandteil für aufladbare Batterien. Und um die Cloud zu betreiben, wird Energie benötigt, die noch immer oft auf Erdöl basiert.

the cozy bedroom was filled with warm light when the rustling of the linen bed sheets triggered a sudden invasion of people listening

Bei diesem Bild geht es um die Datensammlung im Privatbereich: Wir geben Sprachassistenten Plätze in den intimsten Räumen unseres Zuhauses. Smartwatches und Mobiltelefone erfassen Bewegungsdaten direkt an unseren Körpern. „Smarte“ Technologie ist jedoch alles andere als fehlerfrei: Dass Audioaufnahmen von persönlichen Auseinandersetzungen und anderen intimen Momenten versehentlich vom Smartspeaker an die Server von Amazon & Co. geschickt werden, sind keine Einzelfälle. Denn das Triggern des Sprachassistenten geschieht oft, ohne das „Wakeword“ zu sagen. Manchmal genügt zum Beispiel das Geräusch eines Reißverschlusses. Die Sammlung von Daten so dicht am Menschen stellt uns vor grundlegende Fragen des Datenschutzes. Wie viel unserer Privatsphäre sind wir willens zu geben und wofür?

a queue of people from different ethnic and cultural backgrounds casting long and short shadows, some throwing no shadows at all

Die Modelle, die von der KI-Forschung produziert werden, vereinfachen die Wirklichkeit drastisch und verzerren sie häufig. Das beginnt bereits bei der Datensammlung. Dabei werden die Daten von ihrem Kontext gelöst. Sie werden getrennt von den Menschen, Orten und Situationen, in denen sie erzeugt wurden.

Die Tätigkeit des Klassifizierens an sich, also eine der Hauptdisziplinen der KI-Forschung, kann schon als problematisch angesehen werden: Es ist eine Art, Wissen zu erzeugen, aber gleichzeitig limitiert es dieses auch. Ein Bild-Datensatz wie „ImageNet“, der in der Forschung oft Verwendung findet, strukturiert die visuelle Welt nach einer begrenzten Anzahl von begrifflichen Kategorien – alles außerhalb davon existiert nicht. Die menschliche Existenz in ihrer Vielfältigkeit und Komplexität wird dadurch verflacht und verzerrt.

modern-day conquistadors pillaging public spaces, grabbing huge swaths of human everyday life expressions

Große Datensätze sind für Machine Learning absolut notwendig. Wo es keine Daten gibt, da kann auch nichts gelernt werden. Bevor es das Internet gab, bemühte sich die KI-Forschung jahrzehntelang, Datensätze manuell zu erstellen. Dann kam das Internet. Es wurde innerhalb der KI-Forschung sofort als eine Art natürliche Ressource betrachtet – etwas, das man sich nehmen kann, ja sogar nehmen muss: Millionen von Selfies in unterschiedlichen Bildkompositionen und Lichtbedingungen (ideal für Gesichtserkennung), Texte und Kommentare zu verschiedensten Themen auf öffentlichen Websites und Social Media (ideal für das Trainieren von Sprachmodellen). Digitale Großkonzerne wie Facebook hatten auf einmal Zugriff auf Unmengen gelabelter Daten, die die Nutzer*innen bereitwillig abgaben. Auch heute noch ist die Praktik des „Scrapens“ Gang und Gäbe: Das Internet wird geschürft ohne vorherige Zustimmung, insbesondere ohne Rücksicht auf geistiges Eigentum oder Persönlichkeitsrechte. Die Logik des Extraktivismus zeigt sich hier genauso wie beim Raubbau an natürlichen Ressourcen.

Alexa Steinbrück

The Literal Unseen

XLab

Künstliche Intelligenz visualisieren

Wie stellen wir uns künstliche Intelligenz (KI) vor? Als blaue, elektrifizierte Gehirne, humanoide Roboter oder sogar als bedrohlichen Terminator?

KI wird oft als etwas Abstraktes betrachtet: Algorithmen, Daten und Denken. Doch KI ist alles andere als abstrakt: vom Abbau seltener Erden, die die materielle Grundlage für die benötigten Hardware-Komponenten bilden, über die Praxis der Datenerfassung, die im öffentlichen Raum oft ungefragt passiert, bis hin zur monotonen Arbeit der Clickworker an den Datensätzen, die für das Training von KI-Modellen unerlässlich sind – nicht zu vergessen das Kohlendioxid, das bei all dem ausgestoßen wird.

Die Bilder dieser Serie wurden mit Hilfe eines KI-Algorithmus erzeugt, der Text in Bilder umwandelt. Die Künstlerin hat die Eingangstexte so formuliert, dass sie einige der übersehenen Aspekte von KI hervorheben. Sprache dient dabei als Remixing-Werkzeug, das Metaphern als sichtbare Realitäten entstehen lässt.

Die Visualisierung von KI mit Hilfe von KI ist ein Prozess von Co-Creation. Es handelt sich also nicht um das beeindruckende Selbstporträt einer superintelligenten KI. Denn das Bild von einem autonom handelnden KI-System mit eigenem Bewusstsein bleibt ein Mythos.

the cloud is made of rocks and lithium brine and crude oil

„The cloud is the backbone of the artificial intelligence industry, and it’s made of rocks and lithium brine and crude oil“, heißt es in Kate Crawfords Buch „Atlas of AI“. Der Begriff „Cloud“ beschreibt Computer-Infrastrukturen, die über das Internet verschiedene Services wie Datenspeicherung oder Rechenkraft bereitstellen. Der Begriff suggeriert etwas Immaterielles und Leichtes. Tatsächlich ist die Cloud nicht weniger materiell als die Smartphones oder Laptops, die wir in unseren Händen halten. Ein KI-System ist ein vielfältiges Netz von Computer-Infrastruktur, von Batterien über Netzwerk-Router bis hin zu großen Datacentern. Nichts davon funktioniert ohne die Minerale aus der Erdkruste. Lithium ist ein zentraler Bestandteil für aufladbare Batterien. Und um die Cloud zu betreiben, wird Energie benötigt, die noch immer oft auf Erdöl basiert.

the cozy bedroom was filled with warm light when the rustling of the linen bed sheets triggered a sudden invasion of people listening

Bei diesem Bild geht es um die Datensammlung im Privatbereich: Wir geben Sprachassistenten Plätze in den intimsten Räumen unseres Zuhauses. Smartwatches und Mobiltelefone erfassen Bewegungsdaten direkt an unseren Körpern. „Smarte“ Technologie ist jedoch alles andere als fehlerfrei: Dass Audioaufnahmen von persönlichen Auseinandersetzungen und anderen intimen Momenten versehentlich vom Smartspeaker an die Server von Amazon & Co. geschickt werden, sind keine Einzelfälle. Denn das Triggern des Sprachassistenten geschieht oft, ohne das „Wakeword“ zu sagen. Manchmal genügt zum Beispiel das Geräusch eines Reißverschlusses. Die Sammlung von Daten so dicht am Menschen stellt uns vor grundlegende Fragen des Datenschutzes. Wie viel unserer Privatsphäre sind wir willens zu geben und wofür?

a queue of people from different ethnic and cultural backgrounds casting long and short shadows, some throwing no shadows at all

Die Modelle, die von der KI-Forschung produziert werden, vereinfachen die Wirklichkeit drastisch und verzerren sie häufig. Das beginnt bereits bei der Datensammlung. Dabei werden die Daten von ihrem Kontext gelöst. Sie werden getrennt von den Menschen, Orten und Situationen, in denen sie erzeugt wurden.

Die Tätigkeit des Klassifizierens an sich, also eine der Hauptdisziplinen der KI-Forschung, kann schon als problematisch angesehen werden: Es ist eine Art, Wissen zu erzeugen, aber gleichzeitig limitiert es dieses auch. Ein Bild-Datensatz wie „ImageNet“, der in der Forschung oft Verwendung findet, strukturiert die visuelle Welt nach einer begrenzten Anzahl von begrifflichen Kategorien – alles außerhalb davon existiert nicht. Die menschliche Existenz in ihrer Vielfältigkeit und Komplexität wird dadurch verflacht und verzerrt.

modern-day conquistadors pillaging public spaces, grabbing huge swaths of human everyday life expressions

Große Datensätze sind für Machine Learning absolut notwendig. Wo es keine Daten gibt, da kann auch nichts gelernt werden. Bevor es das Internet gab, bemühte sich die KI-Forschung jahrzehntelang, Datensätze manuell zu erstellen. Dann kam das Internet. Es wurde innerhalb der KI-Forschung sofort als eine Art natürliche Ressource betrachtet – etwas, das man sich nehmen kann, ja sogar nehmen muss: Millionen von Selfies in unterschiedlichen Bildkompositionen und Lichtbedingungen (ideal für Gesichtserkennung), Texte und Kommentare zu verschiedensten Themen auf öffentlichen Websites und Social Media (ideal für das Trainieren von Sprachmodellen). Digitale Großkonzerne wie Facebook hatten auf einmal Zugriff auf Unmengen gelabelter Daten, die die Nutzer*innen bereitwillig abgaben. Auch heute noch ist die Praktik des „Scrapens“ Gang und Gäbe: Das Internet wird geschürft ohne vorherige Zustimmung, insbesondere ohne Rücksicht auf geistiges Eigentum oder Persönlichkeitsrechte. Die Logik des Extraktivismus zeigt sich hier genauso wie beim Raubbau an natürlichen Ressourcen.