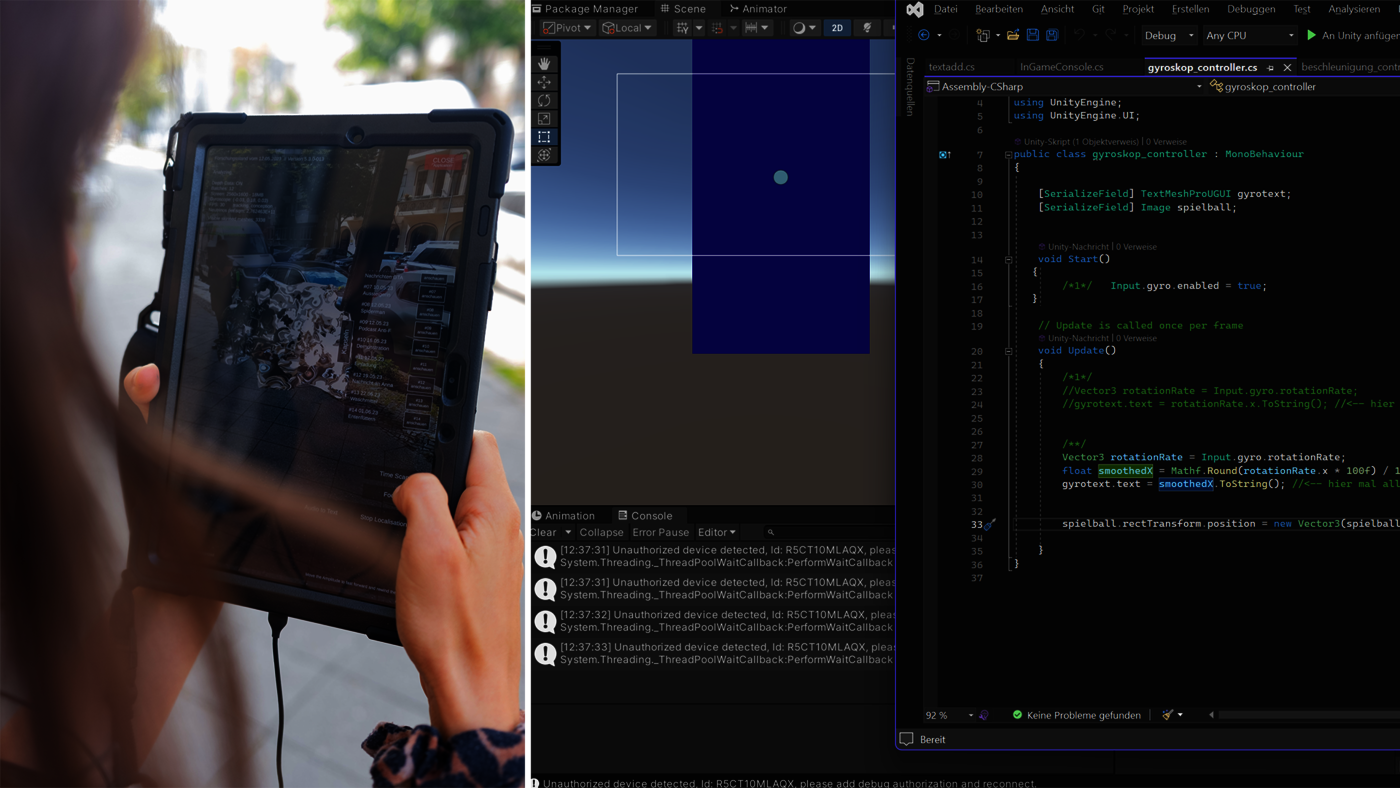

Mobile Geräte wie das Smartphone oder Tablet bieten eine flexible Plattform und eröffnen spannende Gestaltungsmöglichkeiten, wie etwa Augmented Reality (AR). Darüber hinaus lassen sich zahlreiche Sensoren eines Mobilgeräts auslesen und nutzen: Gyroskop, Kamera, Vibration, GPS etc..

Im Kurs tauchen wir in diese Möglichkeiten ein: von den Systemvoraussetzungen über die Build-Pipeline bis hin zu Debugging für mobile Geräte. Wir erkunden verschiedene AR-Techniken und lernen die Grundlagen der Arbeit mit AR Foundation kennen. Zudem testen wir die vielfältigen Sensoren eines Smartphones und entwickeln eigene kleine Anwendungsbeispiele.

Wir arbeiten im Kurs mit Unity auf Windows und Android. Wer seine eigenen Endgeräte (Smartphone, Tablet) oder Arbeitsgeräte (Laptop) mitbringen möchte, kann das gerne tun. Für das Nutzen der Sensorik sind die allermeisten Geräte geeignet, für AR-Foundation gibt es hier eine Liste der fähigen Geräte. Eine kleine Anzahl an AR-fähigen Geräten wird außerdem für den Kurs zu Verfügung stehen.

(Die Build-Pipeline von Mac auf IPhone wird nicht Teil des Kurses sein. Wer das trotzdem unbedingt machen möchte, kann sich gerne an mich wenden und wir schauen, inwieweit das innerhalb des Kurses sinnvoll ist.)

Teilnahmevoraussetzungen

Unity Grundkenntnisse

Kursbegrenzung

Maximal 15 Teilnehmer*innen

Anmeldung

via Mail an Judith Hanke, ed.ellah-grub]ta[eknahj

Hinweis für Studierende mit Studienbeginn vor dem Wintersemester 2022

Für Studierende, die ihr Studium vor dem Wintersemester 2022 begonnen haben, wird dieses Modul nach vorherigem Studienplan unter EK angerechnet.